#27 - 06/2023

- 01001100110127 – cyborg

- ασθένεια είναι η μη συμμόρφωση... (ο μπηχεβιορισμός ως νυστέρι...)

- μια συζήτηση περί τεχνητής νοημοσύνης (κάπου μακριά...)

- έχουν τύψεις οι μηχανές;

- το ερώτημα του παπαγάλου: πόσο μακρυά πετάει η νόηση;

- το μεγάλο άλμα: η ανοσία ως κεφάλαιο, η νοσηρότητα ως επένδυση

- robot wars: η αυτοκρατορία των ΗΠΑ και η γεωπολιτική στη ρομποτική εποχή

- bytes & genes

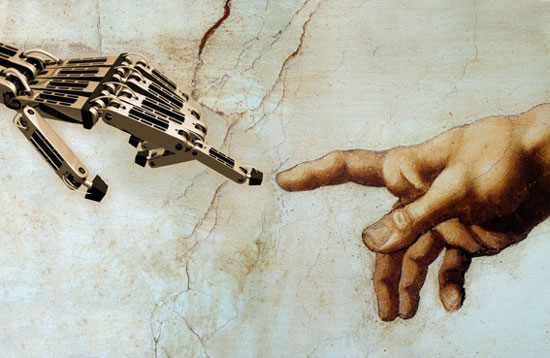

έχουν τύψεις οι μηχανές;

Στη δεκαετία του 1990, λίγο μετά την επιτυχημένη κλωνοποίηση της περίφημης (ή διαβόητης) Ντόλλυ, ένα από τα κυρίαρχα θέματα των τότε συζητήσεων σχετικά με τις νέες τεχνολογίες ήταν και αυτό της «βιοηθικής». Καθώς η Ντόλλυ ήταν το πρώτο θηλαστικό (πρόβατο, για την ακρίβεια) που γεννήθηκε με την τεχνική του γενετικού copy-paste, έχοντας ως πρωτότυπο το γενετικό υλικό ενός άλλου ενηλίκου ατόμου (η κλωνοποίηση από εμβρυικά κύτταρα ήταν εφικτή ήδη από τη δεκαετία του 1980), λογικό κι επόμενο ήταν να γίνουν και οι αντίστοιχες προβολές στο ανθρώπινο είδος. Έχοντας φτάσει σε αυτό το επίπεδο ωριμότητας, οι σχετικές τεχνολογίες δεν απείχαν παρά ένα μόνο βήμα από την ανθρώπινη κλωνοποίηση. Έπρεπε, λοιπόν, να μπουν και κάποιοι «ηθικοί» φραγμοί στην ακατάσχετη επέλαση της γενετικής βιοτεχνολογίας. Όπως κι έγινε. Για την ακρίβεια, βέβαια, οι συζητήσεις περί βιοηθικής, τουλάχιστον μεταξύ των ειδικών, δεν περίμεναν τη γέννηση της Ντόλλυ· είχαν ξεκινήσει νωρίτερα, ήδη από τη δεκαετία του 1970. Για τους εμπλεκόμενους επιστήμονες της γενετικής κοπτο-ραπτικής ήταν αυτονόητο ότι οι όποιοι φραγμοί θα έπρεπε να είναι ελάχιστοι· δεν είναι εξάλλου δυνατό να βάζουμε «εμπόδια στην πρόοδο». Τελικά αποφάσισαν να βάλουν νερό στο κρασί τους μόνο όταν κάποιοι άλλοι ειδικοί, των νομικών επιστημών αυτή τη φορά, τους προειδοποίησαν για τη σοβαρότητα των δικαστικών περιπετειών στις οποίες πιθανόν να εμπλέκονταν αν επέμεναν σε μια σκληροπυρηνική και «ματσό» τακτική ερευνών άνευ ορίων και μηχανισμών λογοδοσίας [1Βλ. τετράδια για εργατική χρήση 7, Η μέλισσα και ο γενετιστής.] (εννοείται φυσικά ότι μόνο όσοι είναι λουδδίτες και εμπαθείς με τους ειδικούς μπορεί να κάνουν παραλληλισμούς με τις μεθόδους των κοινών τραμπούκων που αποθρασύνονται όσο βρίσκουν χώρο και μαζεύονται σαν κουτάβια όποτε βρίσκουν αντίσταση).

Έχοντας μερικές δεκαετίες ζωής πλέον, η «βιοηθική» δεν απολαμβάνει πια τα φώτα της δημοσιότητας, ούτε ακόμα και στις πιο άνευρες κι εξημερωμένες εκδοχές της. Πώς θα μπορούσε άλλωστε, όταν οι υποτελείς των δυτικών κοινωνιών περιμένουν από τη γενετική τη σωτηρία τους· από τον «λοιμό» της όποιας ασθένειας τώρα, ίσως από τον «λιμό» της (κατασκευασμένης) «σπάνης τροφίμων» στο προσεχές μέλλον; Μια άλλη ηθική έχει το προβάδισμα αυτή τη φορά: η ηθική γύρω από τα ζητήματα της τεχνητής νοημοσύνης και των εφαρμογών της. Μάλιστα, στις 22 Μαρτίου του 2023, μερικές χιλιάδες ειδικοί (με μπροστάρη τον Elon Musk) δημοσίευσαν μια ανοιχτή επιστολή [2https://futureoflife.org/open-letter/pause-giant-ai-experiments/ ] στην οποία καλούσαν όλα τα εργαστήρια τεχνητής νοημοσύνης να προχωρήσουν σε μία προσωρινή (εξάμηνη) παύση των ερευνών τους, τουλάχιστον για συστήματα πιο ισχυρά από το GPT-4 [3Το GPT-4 είναι η νέα γενιά των λεγόμενων μεγάλων γλωσσικών μοντέλων. Για περισσότερες λεπτομέρειες, βλ. Cyborg, τ. 26, “τεχνητή νοημοσύνη”: μεγάλα γλωσσικά μοντέλα στην εποχή των «πνευματικών» περιφράξεων.]. Αν δεν το έπρατταν αυτό οικειοθελώς, τότε (πάντα σύμφωνα με την επιστολή), τα κράτη όφειλαν να επέμβουν και να επιβάλουν ένα σχετικό μορατόριουμ. Όπως και πριν 50 χρόνια με την βιοηθική (τι σύμπτωση, άραγε!), έτσι και τώρα, οι αντιδράσεις απέναντι στη συγκεκριμένη πρόταση υπήρξαν επιεικώς αρνητικές, τόσο από τον τύπο όσο και από άλλους επιφανείς ειδικούς. Φυσικά, κανείς δεν αρνείται (τουλάχιστον στα λόγια) την ανάγκη ύπαρξης ενός ηθικού πλαισίου που θα διέπει την ανάπτυξη και τη λειτουργία των εφαρμογών τεχνητής νοημοσύνης. Το φλέγον ζήτημα αφορά βεβαίως στο πώς ακριβώς και πόσο διασταλτικά θα πρέπει να ερμηνευτεί το όποιο τέτοιο ηθικό πλαίσιο.

Γιατί όμως υφίσταται τώρα αυτή η ανάγκη ρύθμισης της τεχνητής νοημοσύνης; Πρωτόκολλα ασφαλείας για την ανάπτυξη λογισμικού υπάρχουν ούτως ή άλλως και (υποτίθεται ότι) ακολουθούνται, τουλάχιστον σε εφαρμογές κρίσιμης σημασίας. Τι είναι αυτό που διαφοροποιεί την τεχνητή νοημοσύνη από άλλες εφαρμογές και που επομένως επιβάλλει τη θέσπιση ειδικών ρυθμιστικών κανόνων; Από «τεχνική» άποψη (που δεν είναι απλά τεχνική, όπως θα φανεί παρακάτω), το «πρόβλημα» με τους αλγορίθμους τεχνητής νοημοσύνης είναι το γεγονός ότι λειτουργούν «απρόβλεπτα». Με άλλα λόγια, δεν είναι πάντα γνωστό εκ των προτέρων το πώς θα αντιδράσουν και τι έξοδο θα παραγάγουν.

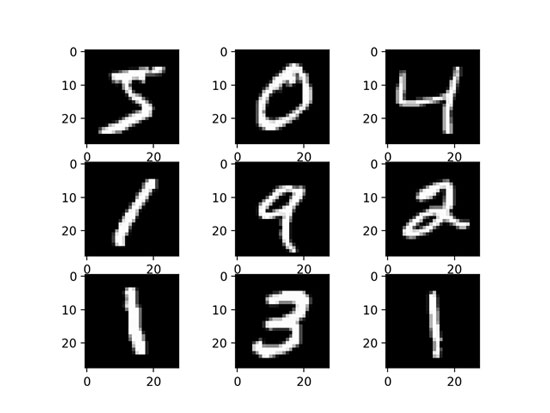

Ένα παράδειγμα ίσως να είναι χρήσιμο σε αυτό το σημείο. Έστω ότι θέλουμε να κατασκευάσουμε ένα σύστημα που να αναγνωρίζει αριθμητικά ψηφία γραμμένα στο χέρι. Θα μπορεί κάποιος να δίνει στο σύστημα αυτό ένα χαρτάκι στο οποίο θα έχει γράψει ένα νούμερο και το σύστημα θα πρέπει να μπορεί να αναγνωρίσει το νούμερο. Ας παρακάμψουμε εδώ το ζήτημα του πώς σκανάρεται αυτό το χαρτάκι και ας υποθέσουμε ότι το σύστημά μας θα δέχεται στην είσοδό του μια ψηφιακή, ασπρόμαυρη εικόνα για κάθε ψηφίο υπό τη μορφή ενός πίνακα δύο διαστάσεων από πίξελ. Το υπόβαθρο της εικόνας θεωρούμε ότι είναι μαύρο και τα πίξελ που ανήκουν στο ψηφίο είναι λευκά. Για έναν προγραμματιστή που θα έπρεπε να υλοποιήσει ένα τέτοιο σύστημα, μια απλή λύση θα ήταν να παρατηρήσει τον πίνακα κάθε ψηφίου, να δει σε ποιες θέσεις τα πίξελ είναι μαύρα και σε ποιες άσπρα και να προσπαθήσει μετά να εισαγάγει στο πρόγραμμά του όλες αυτές τις συνθήκες. Για παράδειγμα, αν το 1 αναπαρίσταται ως μια απλή, κάθετη, άσπρη γραμμή, τότε μόνο τα πίξελ στο μέσο της οριζόντιας διάστασης θα πρέπει να είναι άσπρα. Επομένως, ο προγραμματιστής θα μπορούσε ειδικά για το 1 να βάλει τις σχετικές συνθήκες στο πρόγραμμά του: αν το πίξελ στη θέση (1,1) είναι μαύρο και στη θέση (1,2) είναι μαύρο κ.ο.κ. και στη θέση (1,15) είναι άσπρο κ.ο.κ., τότε το η εικόνα αντιστοιχεί στο ψηφίο 1. Την ίδια λογική θα μπορούσε να ακολουθήσει για όλα τα υπόλοιπα ψηφία.

Το προφανές πρόβλημα με αυτή τη λύση είναι βέβαια ότι δεν γράφουν όλοι οι άνθρωποι με τον ίδιο τρόπο. Ακόμα και ο ίδιος άνθρωπος μπορεί τη μία φορά να γράψει το ένα ως μια απλή κάθετη γραμμή και μια άλλη φορά να της προσθέσει το «καπελάκι» της. Υπάρχουν, επομένως, πολλαπλές παραλλαγές γραφής των ψηφίων. Συνεπώς, ο προγραμματιστής μας θα έπρεπε να λάβει υπόψιν του όλες αυτές τις παραλλαγές (αν το 1 έχει «καπελάκι» ή όχι, αν έχει κάποια κλίση, πόσο παχύ είναι κτλ) και να τις προσθέσει ως επιπλέον συνθήκες στο πρόγραμμά του. Το πλεονέκτημα αυτής της μεθόδου είναι βέβαια ότι μπορεί κανείς να γνωρίζει επακριβώς πώς λειτουργεί ο αλγόριθμος και ποιες συνθήκες ικανοποιούνται κάθε φορά ώστε ένα χειρόγραφο ψηφίο να αναγνωριστεί ως το 1. Το μειονέκτημα είναι ότι γίνεται σχεδόν αδύνατο για έναν άνθρωπο να μπορεί να προβλέψει εκ των προτέρων όλες τις διαφορετικές παραλλαγές των ψηφίων ώστε να τις ενσωματώσει στο πρόγραμμά του· πέραν του γεγονότος ότι πρόκειται για μια αρκετά επίπονη διαδικασία. Τέτοια προβλήματα λύνονται ενίοτε σχετικά εύκολα με μεθόδους τεχνητής νοημοσύνης. Το συγκεκριμένο πρόβλημα αναγνώρισης ψηφίων δε αποτελεί κλασσική άσκηση για τα νευρωνικά δίκτυα, όπως αυτά που χρησιμοποιούνται πίσω από τα μεγάλα γλωσσικά μοντέλα [4Βλ. πάλι Cyborg, τ. 26, “τεχνητή νοημοσύνη”: μεγάλα γλωσσικά μοντέλα στην εποχή των «πνευματικών» περιφράξεων.]. Δεν χρειάζεται κανείς να «πει» σε ένα νευρωνικό δίκτυο όλες τις συνθήκες που ανταποκρίνονται σε κάποιο ψηφίο. Λόγω της δομής του, αν του δοθούν τα κατάλληλα δεδομένα, μπορεί να «μάθει», μέσω ειδικών αλγορίθμων, αυτές τις συνθήκες και να τις κωδικοποιήσει στα βάρη του υπό τη μορφή αριθμών και συναρτήσεων. Μαθαίνει, δηλαδή, όλους εκείνους τους συνδυασμούς από άσπρα και μαύρα πίξελ που στατιστικά είναι πιο πιθανό να αντιστοιχούν στο 1, στο 2, κ.ο.κ.

Κάποιες διαφορές μεταξύ ενός παραδοσιακού αλγορίθμου κι ενός αλγορίθμου τεχνητής νοημοσύνης γίνονται επομένως προφανείς. Στην πρώτη περίπτωση, όπως έχουμε ήδη αναφέρει, δεδομένης μιας εισόδου, η διαδρομή που θα ακολουθήσει ο αλγόριθμος είναι προδιαγεγραμμένη. Στη δεύτερη περίπτωση, η διαδρομή που θα ακολουθήσει ο αλγόριθμος (π.χ., οι κόμβοι που θα ενεργοποιηθούν σε ένα νευρωνικό) εξαρτάται σε μεγάλο βαθμό από το πώς έχει εκπαιδευτεί και τι δεδομένα έχει ήδη δει, κάτι που σπανίως μπορεί να προκαθοριστεί με ακρίβεια (και που δεν είναι επιθυμητό ούτως ή άλλως). Με άλλα λόγια, για να μάθουμε ποια ακριβώς θα είναι η έξοδος ενός αλγορίθμου τεχνητής νοημοσύνης, πρέπει πρώτα να τον τρέξουμε. Ένα δεύτερο διαφοροποιητικό χαρακτηριστικό είναι ότι τέτοιοι αλγόριθμοι μπορούν να τρέχουν και σε «πραγματικό χρόνο», με την έννοια ότι έχουν την ικανότητα να ανταποκριθούν ακόμα και σε «ερεθίσματα» που δεν έχουν ξαναδεί. Ένας παραδοσιακός αλγόριθμος, αν δεν μπορέσει να βρει όλες τις συνθήκες που τον ικανοποιούν, απλά θα «σκάσει». Οι αλγόριθμοι τεχνητής νοημοσύνης, από την άλλη, σχεδιάζονται έτσι ώστε να μπορούν να συνεχίζουν να παράγουν έξοδο ακόμα και για εισόδους που δεν έχουν ξανασυναντήσει. Για αυτούς τους λόγους είναι επομένως που οι αλγόριθμοι τεχνητής νοημοσύνης φαίνεται να διαθέτουν μια «αυτονομία» δράσης: αυτό που τους έχουν εισαγάγει οι προγραμματιστές τους είναι η μέθοδος με βάση την οποία μαθαίνουν κάτι (π.χ., πώς να αλλάζουν τα βάρη ενός νευρωνικού δικτύου ώστε αυτό να αναγνωρίζει ψηφία), αλλά όχι ακριβείς κανόνες. Επομένως, έχουν τη δυνατότητα να δρουν και σε περιβάλλοντα που δεν είναι απολύτως ελεγχόμενα, με τα αυτόνομα αυτοκίνητα να είναι το κλασσικό παράδειγμα εδώ.

Ενώ, λοιπόν, ορισμένα «ηθικά» (και στην ουσία τους πολιτικά, για να είμαστε πιο ακριβείς) ζητήματα αφορούν εν γένει σε κάθε αλγόριθμο που αναμένεται να λειτουργεί ως ένα μικρό γραναζάκι μέσα στην επερχόμενη ουτοπία της 4ης βιομηχανικής επανάστασης, κάποια άλλα ανακύπτουν λόγω της ειδικής φύσης των αλγορίθμων τεχνητής νοημοσύνης. Ένα παράδειγμα από την πρώτη κατηγορία αποτελούν και τα ζητήματα ιδιωτικότητας και εκμετάλλευσης των προσωπικών δεδομένων (και που αποτελούσαν στόχο του φιλόδοξου αλλά μάλλον θνησιγενούς GDPR). Καμμία εξελιγμένη τεχνητή νοημοσύνη δεν είναι απαραίτητη για να αντληθεί υπεραξία (οικονομική ή πολιτική) από τα προσωπικά δεδομένα και τη συνεχή καταγραφή τους, αν και φυσικά η ύπαρξη «έξυπνων» αλγορίθμων μπορεί να μεγεθύνει αυτή την αξία.

Τι γίνεται όμως στις περιπτώσεις όπου πρέπει να αποδοθούν (ακόμα και νομικές) ευθύνες για κάποια προβληματική συμπεριφορά ή κάποια αστοχία; Σε ένα αεροπορικό δυστύχημα, η έρευνα που ακολουθεί μπορεί να καταλήξει στο αν αυτό οφειλόταν σε ανθρώπινο λάθος του πιλότου, σε δομικά προβλήματα της ατράκτου (οπότε έχουν ανάλογη ευθύνη οι μηχανικοί) ή σε σφάλματα στον κώδικα του αυτόματου πιλότου (οπότε το βάρος της ευθύνης πέφτει στους προγραμματιστές). Η απόδοση ευθυνών εδώ είναι εφικτή λόγω της κυριαρχίας (έστω κατά φαντασία και κατά ιδεολογία) της αντίληψης περί ντετερμινιστικής ακολουθίας ορισμένων συμβάντων, π.χ., ο κώδικας θα έπρεπε να προβλέπει ότι οι τιμές μιας συγκεκριμένης μεταβλητής μπορούν να γίνουν και αρνητικές, κάτι που ωστόσο δεν το έκανε, άρα πρόκειται για σφάλμα του προγραμματιστή. Σε ένα δυστύχημα όπου εμπλέκεται όμως ένα αυτόνομο αυτοκίνητο, πού ακριβώς πρέπει να αποδοθούν οι ευθύνες; Μήπως στον οδηγό που επέτρεπε στο αυτοκίνητο να κινείται αυτόνομα ακόμα και σε περιβάλλον που δεν ήταν «κατάλληλο»; Και πώς ακριβώς πρέπει να ξέρει ο οδηγός πότε πρέπει να επιβλέπει το αυτοκίνητο και πότε να το εμπιστεύεται; Μήπως είναι υπεύθυνοι οι κατασκευαστές των αισθητήρων που ενδεχομένως έχουν μια καθυστέρηση μερικά ms μεγαλύτερη απ’ όσο θα χρειάζονταν οι αλγόριθμοι πλοήγησης για να ανταποκριθούν εγκαίρως; Ή μήπως τελικά πρέπει να καταλογιστούν ευθύνες στους προγραμματιστές που δεν προέβλεψαν το ενδεχόμενο ο πεζός να φοράει ασπρόμαυρα, ριγέ ρούχα κι έτσι να μοιάζει με διάβαση μέσα στο σκοτάδι της νύχτας; Αλλά αφού αυτοί οι αλγόριθμοι οφείλουν την επιτυχία τους στο γεγονός ότι (κατά κανόνα) μπορούν να λειτουργούν ακόμα και σε περιπτώσεις που δεν έχουν δει όλα τα πιθανά ερεθίσματα, πώς μπορούμε να κατηγορήσουμε τους προγραμματιστές για το ότι δεν έπραξαν αυτό που δεν όφειλαν να πράξουν από τεχνική άποψη;

Παρόλο που τέτοιες συζητήσεις γύρω από το λεγόμενο ζήτημα του attribution (καταλογισμού) διεξάγονται όντως με μία κάποια ζέση μεταξύ των ειδικών, κατά τη γνώμη μας γίνονται εκ του πονηρού. Δεν υπάρχει καμμία σοβαρή αμφιβολία για το ότι η ευθύνη οφείλει να βαραίνει τον κατασκευαστή - ή χειριστή, αναλόγως της περίπτωσης, όπως π.χ. όταν ένας αξιωματικός δίνει εντολή σε ένα πολεμικό drone για κάποιο χτύπημα. Παρότι τα αυτόνομα συστήματα τεχνητής νοημοσύνης έχουν πράγματι τη δυνατότητα να λειτουργούν σε μη απολύτως ελεγχόμενα περιβάλλοντα, αυτό δεν σημαίνει ότι έχουν σχεδιαστεί για να λειτουργούν σε οποιοδήποτε περιβάλλον.

Υπάρχουν συγκεκριμένα όρια που μπορούν να δεχτούν οι παράμετροί τους και ένα συγκεκριμένο φάσμα συμπεριφορών που μπορεί να αναμένεται από αυτά. Το αν είναι στην πράξη δύσκολο και χρονοβόρο να εντοπιστούν με ακρίβεια αυτά τα εύρη και τα φάσματα, αυτό δεν είναι κάτι που (πρέπει να) αφορά τους τελικούς χρήστες. Και ανάστροφα, πρέπει να τους αφορά το αν για τους κατασκευαστές είναι πολύ πιο εύκολο και προσοδοφόρο να ταΐζουν τα συστήματά τους με όγκους δεδομένων απλά ελπίζοντας ότι κάπου εκεί μέσα θα υπάρχουν αρκετές «προβληματικές» περιπτώσεις ώστε αυτά τα συστήματα να εκπαιδευτούν για αυτές. Θα έπρεπε να τους αφορά το γεγονός ότι οι πόλεις τους, οι συμπεριφορές τους, τα ίδια τους τα σώματα γίνονται τα πεδία δοκιμών (και βολής) των αλγορίθμων τεχνητής νοημοσύνης επειδή οι εναλλακτικές λύσεις των διεξοδικών μελετών ασφαλείας ίσως παραείναι ακριβές για τους κατασκευαστές (τι να θυμίζει άραγε αυτό; Ίσως κάτι άλλες πρόσφατες ερευνητικές δοκιμές στο ψαχνό με κάτι άλλες νέες τεχνολογίες;).

Αυτό το εκ του πονηρού θόλωμα των ορίων πάνω στο ζήτημα του καταλογισμού έχει και κάποια άλλα «πλεονεκτήματα» και για αυτό ίσως να είναι και ζητούμενο. Πρώτον, ζητούμενο άνωθεν, εφόσον πράγματι η «ταιηλοροποίηση» και γραφειοκρατικοποίηση των πολιτικών και οικονομικών αποφάσεων που θα συνεπιφέρει η διάδοση της τεχνητής νοημοσύνης θα επιτρέψει ταυτόχρονα και τον ευκολότερο παραμερισμό των όποιων ηθικών αναστολών - ως γνωστό, ένα πλήκτρο ποτέ δεν είναι απλά ένα πλήκτρο· είναι και μια διαμεσολάβηση που εισάγει την απόσταση, συχνά δε και την ηθική ακηδία. Δεύτερον, ίσως να είναι ζητούμενο ακόμα και κάτωθεν, από τους ίδιους τους οικοτρόφους κι εγκλείστους των (μελλοντικά) έξυπνων πόλεων καθώς θα τους απαλλάσσει από το άγχος του βάρους της ίδιας τους της ύπαρξης, από την υπενθύμιση ότι (θα έπρεπε να) είναι υποκείμενα με έναν ελάχιστο βαθμό αυτονομίας και από τη συνειδητοποίηση της αντίφασης ότι, την ίδια στιγμή που διαθέτουν ένα υπερμεγέθες εγώ, η ζωή τους θα ρυθμίζεται μέχρι και την παραμικρή της λεπτομέρεια από τους επιστάτες τους.

Υπάρχει ωστόσο ένα πραγματικό πρόβλημα «ηθικής» όσον αφορά στις αποφάσεις που (θα) λαμβάνει ένα αυτόνομο σύστημα τεχνητής νοημοσύνης. Ακόμα κι αν μπορούν να αποδοθούν ευθύνες για τέτοιες αποφάσεις, παραμένει το ζήτημα της επεξήγησης του τρόπου με τον οποίο ένα σύστημα έλαβε μια απόφαση. Στους παραδοσιακούς αλγορίθμους είναι εφικτό να ακολουθήσει κανείς το μονοπάτι που τους οδήγησε σε μια συγκεκριμένη έξοδο. Η πλειοψηφία των αλγορίθμων τεχνητής νοημοσύνης αυτή τη στιγμή αποτελούνται από αλλεπάλληλα στρώματα περίπλοκων μαθηματικών συναρτήσεων βασικός σκοπός των οποίων είναι να εντοπίζουν στατιστικά μοτίβα μέσα στα δεδομένα. Προκύπτει επομένως μια διπλή εμπλοκή σε αυτό το σημείο. Πρώτον, δεν υφίσταται ένα μονοπάτι (με την παραδοσιακή έννοια) που ακολουθεί ο αλγόριθμος, αλλά πολλαπλές συναρτήσεις που (απ-)ενεργοποιούνται ταυτόχρονα και η καθεμία συμβάλλει κατά ένα ποσοστό στο τελικό αποτέλεσμα. Συνεπώς, δεν μπορεί να εντοπιστεί με ακρίβεια ποια από όλες αυτές τις συναρτήσεις «ευθύνεται» για το όποιο αποτέλεσμα. Δεύτερον, ακόμα κι αν αυτό ήταν δυνατό, θα παρέμενε εξαιρετικά δύσκολο να εξηγήσει κανείς με ανθρωπίνως κατανοητό τρόπο την όποια απόφαση ενός συστήματος· προφανώς δεν θα είχε νόημα απλά να παραθέσει μερικούς στατιστικούς τύπους ως εξήγηση. Εδώ είναι λοιπόν που ανακύπτει το πρόβλημα του «μαύρου κουτιού» της τεχνητής νοημοσύνης, δηλαδή το γεγονός ότι πολλά από τα σχετικά συστήματα, παρότι πιάνουν υψηλές αποδόσεις (π.χ., αναγνωρίζουν χειρόγραφα ψηφία με μεγάλη ακρίβεια), λειτουργούν με εντελώς αδιαφανείς τρόπους, μη επιτρέποντας ακόμα και στους κατασκευαστές τους να κατανοήσουν τους ακριβείς λόγους που φτάνουν στα όποια συμπεράσματά τους.

Αυτή η αδιαφάνεια είναι φυσικά πρόβλημα, ακόμα και αν τη δει κανείς από τεχνική και μόνο σκοπιά. Όταν ένα τεχνικό σύστημα δεν συμπεριφέρεται με τον τρόπο που θα ήθελες, τότε μάλλον θα ήταν καλό να ξέρεις τις αιτίες της ανεπιθύμητης συμπεριφοράς για να μπορέσεις να τη διορθώσεις. Το τεχνικό κομμάτι ωστόσο ίσως να μην είναι το πιο σημαντικό. Δεν λείπουν εξάλλου οι επιστήμονες οι οποίοι, μέσα στην τετραπέρατη σοφία τους, δεν διστάζουν να δηλώσουν ότι ούτως ή άλλως και ο εγκέφαλός μας είναι ένα μαύρο κουτί, αλλά, παρ’ όλα αυτά τον εμπιστευόμαστε: «Χρησιμοποιείς τον εγκέφαλό σου όλη την ώρα, τον εμπιστεύεσαι όλη την ώρα, χωρίς να έχεις την παραμικρή ιδέα για το πώς δουλεύει» [5Βλ. Can we open the black box of AI? στην επιθεώρηση Nature.]. Άρα, πάει η λογική, γιατί θα έπρεπε να κατανοείς τα τεχνουργήματα που κατασκευάζεις; Προκύπτει όμως ένα θέμα εμπιστοσύνης πολύ ευρύτερης από τα στενά όρια που μπορεί να συλλάβει ο νους ενός μακάριου ειδικού. Κοινωνικής εμπιστοσύνης, για την ακρίβεια. Αν το αυτόνομο αυτοκίνητο που οδηγάς (ή σε οδηγάει) τρακάρει και κανείς δεν μπορεί να σου εξηγήσει μετά για ποιον λόγο δεν σταμάτησε στο κόκκινο φανάρι, μάλλον θα το σκεφτείς δυο και τρεις φορές πριν το χρησιμοποιήσεις ξανά. Κι αν αυτό είναι κάτι που επαναλαμβάνεται και γίνει κοινωνική γνώση ότι «αυτά είναι μαύρα κουτιά που κάνουν ό,τι τους κατέβει», τότε το δυναμικό διάδοσης της τεχνητής νοημοσύνης (μαζί με τα αντίστοιχα κονδύλια) δεν αποκλείεται να εξαερωθεί απότομα [6Ως αντίστοιχο παράδειγμα, μπορεί να σκεφτεί κανείς τα μεγάλα γλωσσικά μοντέλα τύπου ChatGPT. Παρότι αρχικά έκαναν μεγάλη εντύπωση, γρήγορα έγιναν εμφανείς οι σοβαροί περιορισμοί τους σε βαθμό που κανείς δεν θα σκεφτόταν σοβαρά να τα χρησιμοποιήσει σε εργασίες κρίσιμης σημασίας. Όλοι πλέον περιμένουν τις επόμενες, αναβαθμισμένες και διορθωμένες εκδόσεις. Αποτελεί στοίχημα για αυτά τα μοντέλα το να καταφέρουν να πείσουν ότι είναι κάτι παραπάνω από χαριτωμένα παιχνίδια.].

Το ίδιο μπορεί να ισχύει και όταν τέτοια συστήματα λαμβάνουν αποφάσεις που είναι καταφανώς άδικες ή μεροληπτικές (biased), ειδικά όταν μιλάμε για κοινωνίες που ορκίζονται στο όνομα της πολυπολιτισμικότητας και της συμπερίληψης. Δεν έχει περάσει πολύς καιρός από τότε που το chatbot που «απελευθέρωσε» η Microsoft στη διαδικτυακή ζούγκλα εξελίχθηκε σε ένα μισογυνικό φασιστόμουτρο ή από τότε που καταγγέλθηκε το σύστημα προσλήψεων της Amazon ως μεροληπτικό κατά μειονοτήτων. Εδώ οι μηχανικοί βρίσκονται μπροστά σε ένα ενδιαφέρον αδιέξοδο. Στο βαθμό που οι σύγχρονες εκδοχές τεχνητής νοημοσύνης βασίζονται σε δεδομένα για να εκπαιδευτούν (είναι data-driven, όπως αναφέρεται στη σχετική βιβλιογραφία), αναπόφευκτα θα αναπαράγουν στην εσωτερική τους δομή τις συσχετίσεις που μπορούν να ανακαλύψουν σε αυτά τα δεδομένα. Αν τα δεδομένα ενός συστήματος επαγγελματικού προσανατολισμού λένε, π.χ., ότι οι μαύροι έχουν μικρότερες πιθανότητες να γίνουν γιατροί ή δικηγόροι ενώ οι ασιάτες αυξημένες, τότε το μοντέλο τεχνητής νοημοσύνης θα μάθει να αναπαράγει ακριβώς αυτό, αδιαφορώντας για το κατά πόσο είναι συμβατό με την πολιτική ορθότητα ή με τις όποιες ηθικές δεσμεύσεις περί μη διακρίσεων. Οι μηχανικοί επομένως έχουν ορισμένες επιλογές. Είτε να βρούνε «πληρέστερα» δεδομένα, κάτι που δεν είναι πάντα εφικτό. Είτε να «πειράξουν» τα δεδομένα με κατάλληλο τρόπο, π.χ., αφαιρώντας πληροφορίες περί φυλετικής καταγωγής, κάτι που όμως μπορεί να μειώνει την γενική απόδοση του συστήματος. Είτε, τέλος, να προσθέτουν επί τούτου διάφορα χειροκίνητα φίλτρα, ελπίζοντας έτσι ότι το σύστημα θα βγάζει ευπρεπείς απαντήσεις· αυτή είναι και η λύση που έχουν επιλέξει προς το παρόν, επιστρατεύοντας για αυτόν τον λόγο και ολόκληρους στρατούς από (ανθρώπους) εργάτες της τεχνητής νοημοσύνης που δουλεύουν αθόρυβα στα παρασκήνια ώστε να επιτηρούν τα εν λόγω συστήματα.

Αρκετά προβλήματα μπορεί να εντοπίσει κανείς στις απέλπιδες προσπάθειες των μηχανικών να αναγκάσουν τα συστήματά τους να ενδοβάλουν ένα ελάχιστο ηθικής ακεραιότητας και αντικειμενικότητας. Ακόμα και όταν γίνεται λόγος για ένα τεχνικό σύστημα, καμμία αμεροληψία δεν υφίσταται, αν με αυτόν τον όρο εννοεί κανείς κάποιο είδος ψυχρής αντικειμενικότητας. Κάθε σύστημα και κάθε άνθρωπος έχει τις «προκαταλήψεις» του ή, διαφορετικά ειπωμένο, τις αξιακές τους δεσμεύσεις. Αυτές οι «προκαταλήψεις» δεν λειτουργούν πάντα εις βάρος της αντικειμενικής θέασης της πραγματικότητας (αν και όντως το κάνουν αυτό συχνά), αλλά ορισμένες φορές λειτουργούν επικουρικά όσον αφορά στην εναργέστερη θέαση της. Αναλαμβάνουν τον ρόλο διανοητικών οδοδεικτών ώστε να καθοδηγήσουν κάποιον προς μια συνεκτική εξήγηση αυτού που βλέπει μπροστά του και να τον «γλιτώσουν» από το χάος των πολλαπλών ερμηνειών [7Βλ. Explanation in artificial intelligence: Insights from the social sciences, Tim Miller, περ. Artificial Intelligence, 2019.]. Εν πάση περιπτώσει, αποτελεί χίμαιρα των μηχανικών η αναζήτηση κάποιου αντικειμενικού συστήματος τεχνητής νοημοσύνης, υπεράνω των ανθρωπίνων παθών. Πάντα θα έχουν κάποια αξιακή φόρτιση τα συγκεκριμένα συστήματα. Το ερώτημα είναι ποιος θα τα φορτίζει και προς το συμφέρον ποιου; Επιπλέον, αποτελεί σοβαρή παρανόηση το να θεωρεί κανείς ότι η «ηθική» μπορεί να κωδικοποιηθεί «απλά» σε φορμαλιστικούς, υπολογιστικούς κανόνες και αυτοί μετά «απλά» να ενσωματωθούν στους αλγορίθμους τεχνητής νοημοσύνης. Ως κοινωνικό προϊόν, καμμία ηθική δεν είναι δυνατό να αναχθεί σε απλές και τυποποιημένες συνταγές που θα επιτρέπουν στους μηχανικούς να κοιμούνται ήσυχοι τα βράδια, θεωρώντας ότι έκαναν το καθήκον τους επειδή πρόσθεσαν έναν κανόνα στο ChatGPT που να λέει ότι ποτέ δεν πρέπει να εκφράζει απόψεις σαν αυτές των αμερικάνων ρεπουμπλικανών.

Ήταν άραγε μοιραία αυτή η εξέλιξη, ακολουθώντας ίσως κάποια τεχνική νομοτέλεια που επέβαλε στα συστήματα τεχνητής νοημοσύνης να γίνουν αυτά τα αδηφάγα τέρατα ακατανόητων και περίπλοκων στρωμάτων από εξισώσεις και συναρτήσεις στατιστικού τύπου; Η απάντηση σε αυτό το ερώτημα είναι μάλλον αρνητική [8Βλ. Shortcuts to Artificial Intelligence του Nello Cristianini από το βιβλίο Machines We Trust: Perspectives on Dependable AI.]. Η τεχνητή νοημοσύνη δεν είχε πάντα στο επίκεντρό της τέτοιες μεθόδους «μαύρου κουτιού» οι οποίες χρειάζονται τεράστιους όγκους δεδομένων για να βρουν στατιστικές συσχετίσεις. Υπάρχει, υπήρξε και κάποτε ήταν κυρίαρχη μια άλλη κατηγορία μεθόδων η οποία βασίζεται στον χειρισμό λογικών κανόνων και στην ικανότητα ενός συστήματος να εξάγει συμπεράσματα από κάποια αρχικά δεδομένα και μερικούς τέτοιους κανόνες. Τα τελευταία είκοσι χρόνια αυτές οι μέθοδοι έχουν μάλλον περιθωριοποιηθεί με τις στατιστικές μεθόδους να κυριαρχούν σχεδόν απόλυτα πια (αν και υπάρχουν κάποιες απόπειρες συνδυασμού τους). Η βασικότερη ίσως διαφορά τους είναι ότι οι στατιστικές μέθοδοι κάνουν ό,τι ακριβώς λέει και το όνομά τους: ανακαλύπτουν συσχετίσεις αδιαφορώντας πλήρως για το αν πίσω από μια συσχέτιση βρίσκεται πράγματι ένας αιτιώδης δεσμός ή όχι. Δεν ενδιαφέρει το πώς ακριβώς προκύπτει ένα συμπέρασμα, αρκεί αυτό να είναι «σωστό». Οι παλαιότερες, συμβολικές μέθοδοι, από την άλλη, απαιτούσαν από τον προγραμματιστή να μπει σε μια διαδικασία μοντελοποίησης όπου έπρεπε να αποστάξει τους κρίσιμους εκείνους κανόνες που θεωρούσε ότι έχουν ιδιαίτερη βαρύτητα. Επρόκειτο βέβαια για μια χρονοβόρα και επίπονη διαδικασία το τελικό αποτέλεσμα της οποίας όμως ήταν ένα σύστημα σχετικά κατανοητό από τους κατασκευαστές και τους χειριστές του.

Οι στατιστικές μέθοδοι τελικά νίκησαν. Τη νίκη τους αυτή όμως την οφείλουν - πέρα από τους όποιους ιδεολογικούς λόγους που υποτιμούν τις αιτιώδεις σχέσεις προς όφελος των στατιστικών συσχετίσεων – και σε ένα γεγονός που δεν είναι απλά τεχνικό αλλά κατά κύριο λόγο κοινωνικό: στην πλημμυρίδα δεδομένων που έγιναν διαθέσιμα λόγω των διαφόρων μεθόδων και συσκευών καταγραφής. Χωρίς τεράστιους όγκους δεδομένων οι στατιστικές μέθοδοι δεν έχουν καμμία χρησιμότητα. Προϋπόθεση για την «καλή υγεία» τους είναι το να καταναλώνουν μεγάλους όγκους δεδομένων ώστε να εκπαιδεύονται κατάλληλα και να ανακαλύπτουν τις όποιες συσχετίσεις.

Σημαντική σημείωση σε αυτό το σημείο. Τα δεδομένα αυτά δεν συλλέγονται πάντα με βάση αυστηρά πρωτόκολλα προστασίας της ιδιωτικότητας και με τη συναίνεση των συμμετεχόντων. Κατά κανόνα συμβαίνει το αντίθετο. Καθώς μια τέτοια μέθοδος συλλογής δεδομένων θα ήταν αρκετά ακριβή και καθόλου βέβαιη ως προς την εξασφάλιση συναίνεσης, οι αλγόριθμοι της (στατιστικής) τεχνητής νοημοσύνης ταΐζονται απλά με δεδομένα που βρίσκονται «εκεί έξω», κατά κάποιον τρόπο «ελεύθερα» διαθέσιμα. Για παράδειγμα, τα μεγάλα γλωσσικά μοντέλα μπορεί να εκπαιδεύονται πάνω στα λήμματα της wikipedia, χωρίς βέβαια κανείς να έχει λάβει τη συναίνεση των συντακτών της. Το σύστημα προτάσεων νέων τίτλων σε ένα ηλεκτρονικό βιβλιοπωλείο εκπαιδεύεται πάνω στα κλικ των πελατών του, έχοντας, στην καλύτερη περίπτωση, αποσπάσει τη συναίνεσή τους με τα γνωστά ερωτήματα περί των cookies.

Αν η σύγχρονη τεχνητή νοημοσύνη έχει λάβει αυτή τη μορφή του κισσού που κρατιέται στη ζωή ρουφώντας με τα πλοκάμια της τα δεδομένα των «χρηστών» της, το επόμενο ερώτημα αφορά βέβαια στους λόγους για τους οποίους αυτά τα δεδομένα έγιναν «ξαφνικά» μια πολύτιμη πρώτη ύλη. Η απάντηση εδώ δεν μπορεί βέβαια να είναι τεχνικής φύσης ούτε αρκεί η δήθεν αφέλεια (που κάποτε ίσως ήταν πραγματική· πλέον μόνο μικρόνοες και υστερόβουλοι έχουν την πολυτέλεια να την υιοθετούν ως άμυνα) περί διευκόλυνσης της καθημερινής ζωής διά της δραπέτευσης προς το σύμπαν των «άυλων» (οικονομικών αλλά και κοινωνικών) συναλλαγών. Τα δεδομένα κάθε είδους έχουν γίνει πρώτη ύλη επειδή, πριν από αυτά, οι ίδιες οι κοινωνικές σχέσεις (ή ακόμα και τα ίδια τα σώματα) έχουν μπει σε μια διαδικασία υπαγωγής στις νόρμες του κεφαλαίου. Η καταγραφή για λόγους επιτήρησης και καταστολής δεν είναι βέβαια κάτι που πρέπει να υποτιμάται. Όμως δεν είναι το μόνο είδος καταγραφής. Πλάι σε αυτή υπάρχει και η καταγραφή που μετατρέπει όλο το πεδίο του κοινωνικού σε ένα σύμπλεγμα από ταιηλορικές αλυσίδες συναρμολόγησης. Συναρμολόγησης προφίλ και εαυτών. Η κατάβαση του κεφαλαίου προς τα ενδότερα των σχέσεων και των σωμάτων γίνεται εφικτή μόνο στο βαθμό που αυτές οι σχέσεις και αυτά τα σώματα ποσοτικοποιούνται και καταγράφονται, στο βαθμό που γίνονται απλές πλατφόρμες μετρήσεων.

Όλες οι συζητήσεις για την ανάγκη ύπαρξης κάποιας «ηθικής» της τεχνητής νοημοσύνης είναι καταδικασμένες να επιπλέουν στην επιφάνεια των πραγμάτων όσο δεν τολμάνε να αγγίξουν αυτόν τον κατά βάση πολιτικό πυρήνα του ζητήματος. Το να επιμένει κάποιος ότι θα πρέπει από τώρα να ενσωματώσουμε στα συστήματα τεχνητής νοημοσύνης τους κανόνες του Ασίμωφ μπορεί να μοιάζει πολύ πιασάρικο, «ευαίσθητο» και φιλοσοφημένο. Όμως είναι «φιλοσοφημένο» με την κακή σημασία της λέξης (κάποιος κακεντρεχής θα μπορούσε να μιλήσει για αμπελοφιλοσοφίες): είναι τόσο «φιλοσοφημένες» αυτές οι συζητήσεις και προτάσεις που μέσα στην αφαίρεσή τους καταφέρνουν τελικά να μην μιλάνε για τίποτα το συγκεκριμένο, λειτουργώντας μάλλον ως συνειδησιακό καταπραϋντικό. Το παράδειγμα της γενετικής έχει τη σημασία του εδώ. Εννοείται φυσικά ότι καλώς θεσπίστηκε ένα ρυθμιστικό πλαίσιο που απαγόρευε την ανθρώπινη κλωνοποίηση. Η επιμονή όμως μόνο σε αυτή την πιο κραυγαλέα πλευρά του ζητήματος λειτούργησε εν μέρει και ως αντιπερισπασμός. Υπάρχουν πάμπολλες άλλες πλευρές της γενετικής που χρειάζονται κριτική ανάλυση. Η όποια τέτοια ανάλυση, όταν και για όσο έγινε, σίγουρα δεν ήταν αρκετή. Τα μεταλλαγμένα τρόφιμα συνάντησαν μια αντίσταση, κυρίως από την ευρώπη, αλλά συνεχίζουν την πορεία τους ακάθεκτα. Και οι γονιδιακές «θεραπείες», σε διάφορες μορφές και με διάφορα ονόματα, φαίνεται πλέον ότι έχουν ανοιχτό δρόμο μπροστά τους. Η κατάσταση με την τεχνητή νοημοσύνη μοιάζει να βρίσκεται σε χειρότερο σημείο, ίσως και γιατί οι σχετικές συζητήσεις ξεκινάνε πλέον από ένα ακόμα χαμηλότερο σημείο διανοητικής (αν-)επάρκειας. Οι μεταφυσικές ονειροφαντασίες του κάθε Kurzweil περί singularity και του κάθε Χαράρι περί Homo Deus βρίσκουν ευήκοα ώτα επειδή απευθύνονται σε υποτελείς που έχουν μάθει να σκέφτονται αντανακλαστικά, με συνθήματα και υπό τους όρους του θεάματος. Είναι και αυτό ένα ακόμα δείγμα επιθυμίας απόδρασης από την αμείλικτη πραγματικότητα. Αυτή η αφηρημένη και φαντασιώδης ηθική της τεχνητής νοημοσύνης που (υποτίθεται ότι) ασχολείται με βαριά υπαρξιακά ερωτήματα δεν μπορεί παρά εν τέλει να εκφυλίζεται σε μια ανώδυνη ηθικολογία, κατάλληλη για να πουλάει κανείς πνεύμα σε ανάλαφρα δείπνα, αλλά πάντως ακατάλληλη για την οποιαδήποτε σοβαρή κριτική.

Separatrix

Σημειώσεις

1 - Βλ. τετράδια για εργατική χρήση 7, Η μέλισσα και ο γενετιστής.

[ επιστροφή ]

2 - https://futureoflife.org/open-letter/pause-giant-ai-experiments/

[ επιστροφή ]

3 - Το GPT-4 είναι η νέα γενιά των λεγόμενων μεγάλων γλωσσικών μοντέλων. Για περισσότερες λεπτομέρειες, βλ. Cyborg, τ. 26, “τεχνητή νοημοσύνη”: μεγάλα γλωσσικά μοντέλα στην εποχή των «πνευματικών» περιφράξεων.

[ επιστροφή ]

4 - Βλ. πάλι Cyborg, τ. 26, “τεχνητή νοημοσύνη”: μεγάλα γλωσσικά μοντέλα στην εποχή των «πνευματικών» περιφράξεων.

[ επιστροφή ]

5 - Βλ. Can we open the black box of AI? στην επιθεώρηση Nature.

[ επιστροφή ]

6 - Ως αντίστοιχο παράδειγμα, μπορεί να σκεφτεί κανείς τα μεγάλα γλωσσικά μοντέλα τύπου ChatGPT. Παρότι αρχικά έκαναν μεγάλη εντύπωση, γρήγορα έγιναν εμφανείς οι σοβαροί περιορισμοί τους σε βαθμό που κανείς δεν θα σκεφτόταν σοβαρά να τα χρησιμοποιήσει σε εργασίες κρίσιμης σημασίας. Όλοι πλέον περιμένουν τις επόμενες, αναβαθμισμένες και διορθωμένες εκδόσεις. Αποτελεί στοίχημα για αυτά τα μοντέλα το να καταφέρουν να πείσουν ότι είναι κάτι παραπάνω από χαριτωμένα παιχνίδια.

[ επιστροφή ]

7 - Βλ. Explanation in artificial intelligence: Insights from the social sciences, Tim Miller, περ. Artificial Intelligence, 2019.

[ επιστροφή ]

8 - Βλ. Shortcuts to Artificial Intelligence του Nello Cristianini από το βιβλίο Machines We Trust: Perspectives on Dependable AI.

[ επιστροφή ]